🚀 ⚡️ 蝗蟲 Mcp 伺服器

一個模型上下文協議(MCP)伺服器實現,用於運行Locust負載測試。這個伺服器使Locust負載測試功能能夠與AI驅動的開發環境無縫集成。

概覽

什麼是 Locust MCP 伺服器?

Locust MCP 伺服器是一個專門的實現,旨在利用 Locust 這個流行的開源負載測試工具來促進負載測試。這個伺服器允許用戶高效地運行負載測試,通過將 Locust 的功能與 AI 驅動的開發環境整合在一起。它提供了一個強大的框架,用於模擬用戶流量並在各種條件下測量系統性能,成為開發人員和測試人員確保其應用程序能夠處理預期負載的必備工具。

Locust MCP 伺服器的特點

- 無縫整合:Locust MCP 伺服器與現有的開發環境無縫整合,便於設置和執行負載測試。

- AI 驅動的能力:利用 AI 技術增強負載測試策略,提供傳統方法可能忽略的見解和優化。

- 可擴展性:該伺服器設計用於處理大量並發用戶,適合測試各種規模的應用程序。

- 實時監控:用戶可以在負載測試期間實時監控其應用程序的性能,實現即時反饋和調整。

- 可自定義場景:創建量身定制的負載測試場景,模擬真實世界的用戶行為,確保測試的相關性和有效性。

如何使用 Locust MCP 伺服器

- 安裝:首先在您的機器或伺服器上安裝 Locust MCP 伺服器。請按照文檔中提供的安裝說明進行操作。

- 配置:配置伺服器設置以符合您的測試需求。這包括設置用戶數量、測試持續時間以及您希望模擬的任何特定場景。

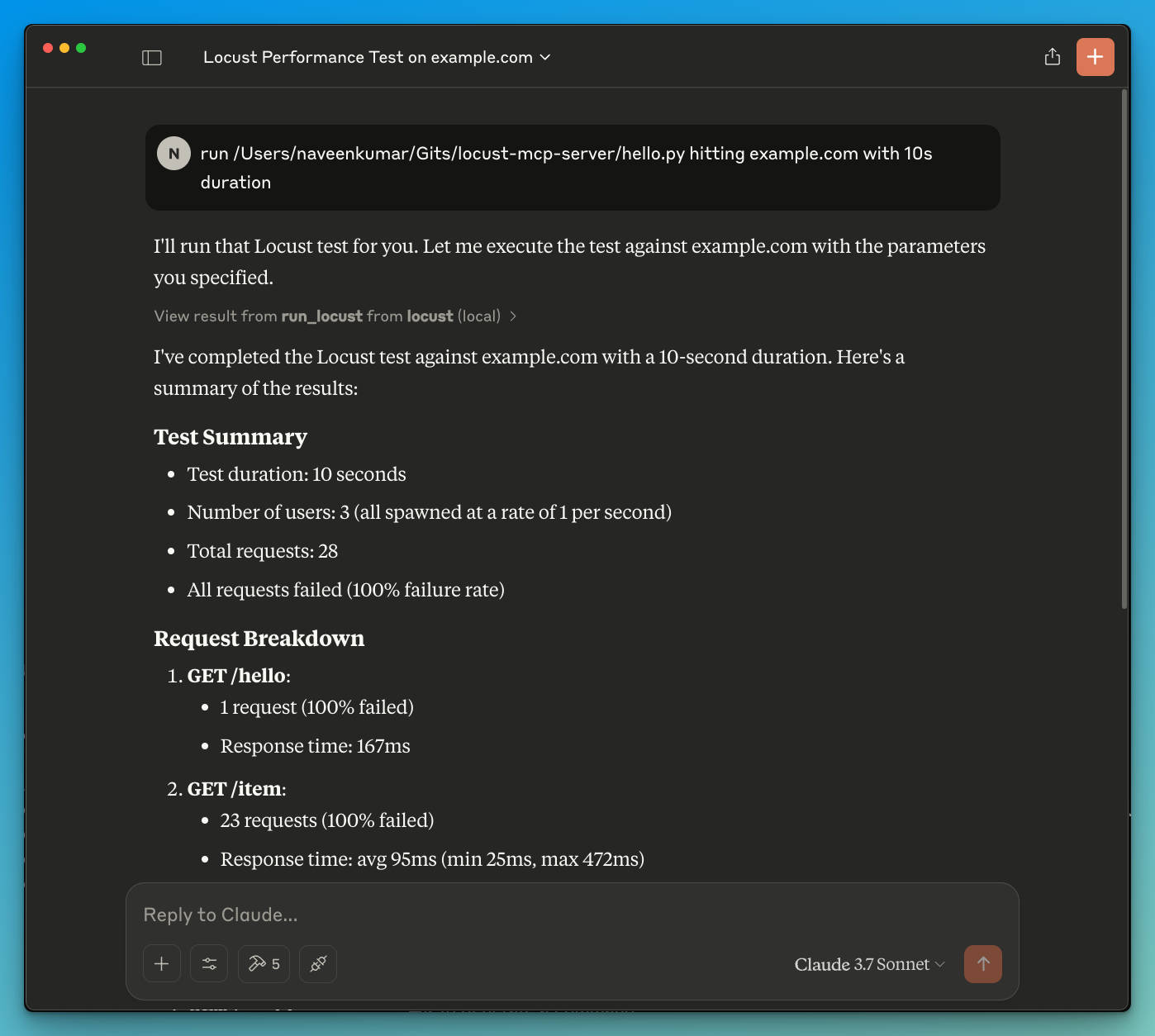

- 運行測試:通過伺服器界面啟動負載測試。實時監控進度和結果,以獲取有關應用程序性能的見解。

- 分析結果:測試完成後,分析結果以識別瓶頸、性能問題和改進的領域。

- 迭代:根據發現,對您的應用程序進行必要的調整,並重複測試過程以確保最佳性能。

常見問題解答

問:Locust MCP 伺服器的主要目的是什么?

答:主要目的是促進應用程序的負載測試,允許開發人員模擬用戶流量並評估在各種條件下的性能。

問:我可以將 Locust MCP 伺服器與其他工具整合嗎?

答:可以,Locust MCP 伺服器設計為與各種開發和測試工具整合,增強其功能和可用性。

問:使用 Locust MCP 伺服器需要付費嗎?

答:Locust MCP 伺服器是開源的,免費使用,讓各種規模的開發人員和組織都能輕鬆訪問。

問:我如何能為 Locust MCP 伺服器項目做出貢獻?

答:歡迎貢獻!您可以通過報告問題、建議功能或通過項目庫提交代碼改進來參與。

問:我可以在哪裡找到有關 Locust MCP 伺服器的更多信息?

答:有關更詳細的信息、文檔和支持,請訪問官方網站 qainsights.com。

詳細

…

伺服器配置

{

"mcpServers": {

"locust-mcp-server": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--qainsights--locust-mcp-server--locust-mcp-server",

"python main.py"

],

"env": {}

}

}

}