🚀 ⚡️ Serveur Locust Mcp

Une implémentation de serveur de Protocole de Contexte de Modèle (MCP) pour exécuter des tests de charge Locust. Ce serveur permet une intégration transparente des capacités de test de charge Locust avec des environnements de développement alimentés par l'IA.

Aperçu

Qu'est-ce que le serveur Locust MCP ?

Le ### serveur Locust MCP est une implémentation spécialisée conçue pour faciliter les tests de charge en utilisant Locust, un outil de test de charge open-source populaire. Ce serveur permet aux utilisateurs d'exécuter des tests de charge de manière efficace en intégrant les capacités de Locust avec des environnements de développement alimentés par l'IA. Il fournit un cadre robuste pour simuler le trafic utilisateur et mesurer les performances du système dans diverses conditions, ce qui en fait un outil essentiel pour les développeurs et les testeurs cherchant à s'assurer que leurs applications peuvent gérer les charges attendues.

Caractéristiques du serveur Locust MCP

- Intégration transparente : Le serveur Locust MCP s'intègre facilement aux environnements de développement existants, permettant une configuration et une exécution aisées des tests de charge.

- Capacités alimentées par l'IA : Exploitez les technologies de l'IA pour améliorer les stratégies de test de charge, fournissant des informations et des optimisations que les méthodes traditionnelles peuvent négliger.

- Scalabilité : Le serveur est conçu pour gérer un grand nombre d'utilisateurs simultanés, ce qui le rend adapté aux tests d'applications de toutes tailles.

- Surveillance en temps réel : Les utilisateurs peuvent surveiller les performances de leurs applications en temps réel pendant les tests de charge, permettant des retours et des ajustements immédiats.

- Scénarios personnalisables : Créez des scénarios de test de charge sur mesure qui imitent le comportement réel des utilisateurs, garantissant que les tests sont pertinents et efficaces.

Comment utiliser le serveur Locust MCP

- Installation : Commencez par installer le serveur Locust MCP sur votre machine ou serveur. Suivez les instructions d'installation fournies dans la documentation.

- Configuration : Configurez les paramètres du serveur pour correspondre à vos exigences de test. Cela inclut la configuration du nombre d'utilisateurs, de la durée du test et de tout scénario spécifique que vous souhaitez simuler.

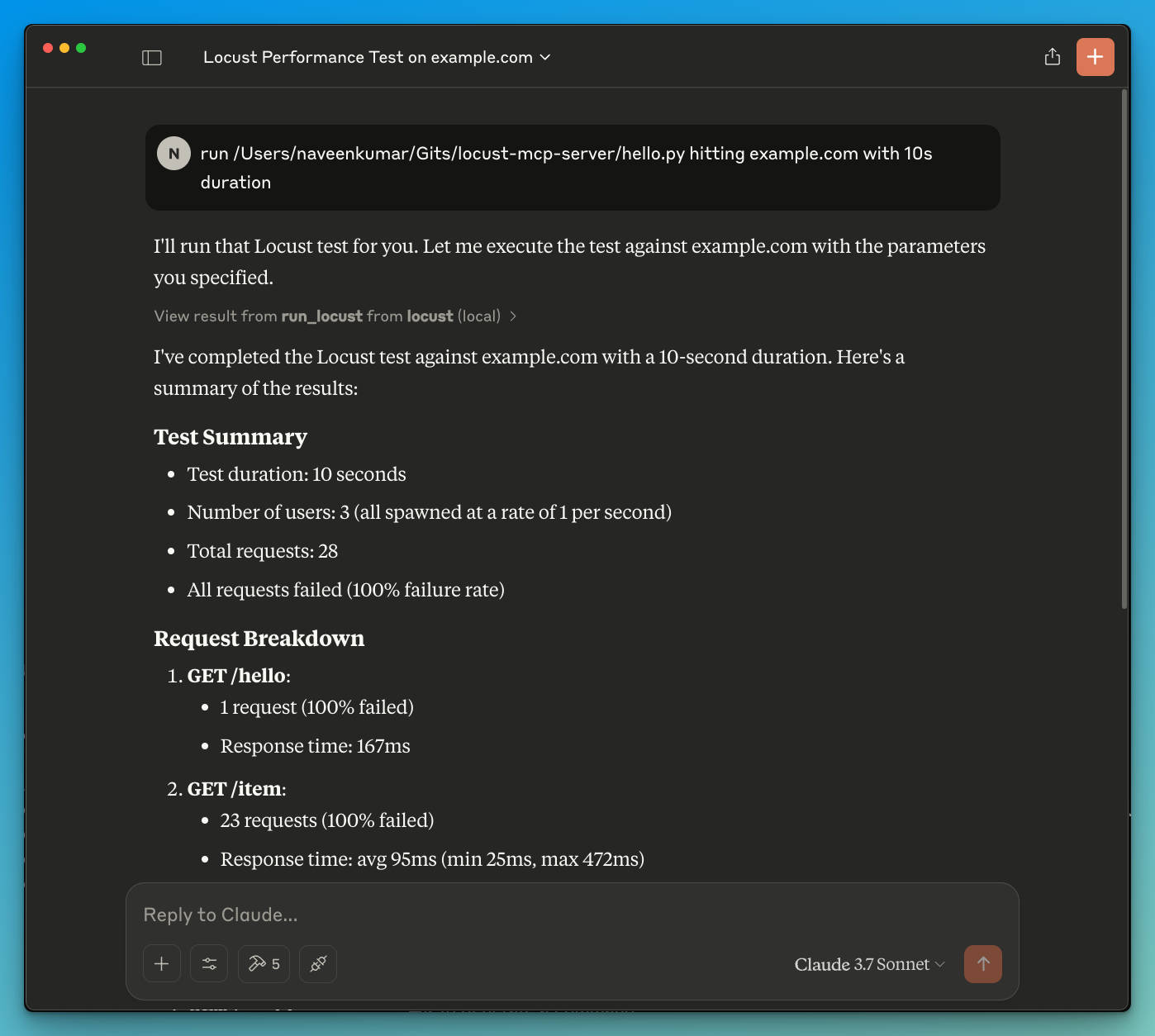

- Exécuter des tests : Démarrez les tests de charge via l'interface du serveur. Surveillez les progrès et les résultats en temps réel pour obtenir des informations sur les performances de votre application.

- Analyser les résultats : Une fois les tests terminés, analysez les résultats pour identifier les goulets d'étranglement, les problèmes de performance et les domaines à améliorer.

- Itérer : En fonction des résultats, apportez les ajustements nécessaires à votre application et répétez le processus de test pour garantir des performances optimales.

Questions Fréquemment Posées

Q : Quel est le but principal du serveur Locust MCP ?

R : Le but principal est de faciliter les tests de charge pour les applications, permettant aux développeurs de simuler le trafic utilisateur et d'évaluer les performances dans diverses conditions.

Q : Puis-je intégrer le serveur Locust MCP avec d'autres outils ?

R : Oui, le serveur Locust MCP est conçu pour s'intégrer à divers outils de développement et de test, améliorant ainsi sa fonctionnalité et son utilisation.

Q : Y a-t-il un coût associé à l'utilisation du serveur Locust MCP ?

R : Le serveur Locust MCP est open-source et gratuit à utiliser, ce qui le rend accessible aux développeurs et aux organisations de toutes tailles.

Q : Comment puis-je contribuer au projet du serveur Locust MCP ?

R : Les contributions sont les bienvenues ! Vous pouvez participer en signalant des problèmes, en suggérant des fonctionnalités ou en soumettant des améliorations de code via le dépôt du projet.

Q : Où puis-je trouver plus d'informations sur le serveur Locust MCP ?

R : Pour des informations plus détaillées, de la documentation et du support, visitez le site officiel à qainsights.com.

Détail

Configuration du serveur

{

"mcpServers": {

"locust-mcp-server": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--qainsights--locust-mcp-server--locust-mcp-server",

"python main.py"

],

"env": {}

}

}

}