🚀 ⚡️ Servidor Locust Mcp

Una implementación de servidor del Protocolo de Contexto de Modelo (MCP) para ejecutar pruebas de carga con Locust. Este servidor permite la integración fluida de las capacidades de pruebas de carga de Locust con entornos de desarrollo impulsados por IA.

Resumen

¿Qué es el Servidor Locust MCP?

El ### Servidor Locust MCP es una implementación especializada diseñada para facilitar pruebas de carga utilizando Locust, una popular herramienta de pruebas de carga de código abierto. Este servidor permite a los usuarios realizar pruebas de carga de manera eficiente al integrar las capacidades de Locust con entornos de desarrollo impulsados por IA. Proporciona un marco robusto para simular el tráfico de usuarios y medir el rendimiento del sistema bajo diversas condiciones, convirtiéndose en una herramienta esencial para desarrolladores y testers que buscan asegurar que sus aplicaciones puedan manejar las cargas esperadas.

Características del Servidor Locust MCP

- Integración Sin Problemas: El Servidor Locust MCP se integra sin problemas con los entornos de desarrollo existentes, permitiendo una fácil configuración y ejecución de pruebas de carga.

- Capacidades Impulsadas por IA: Aprovecha las tecnologías de IA para mejorar las estrategias de pruebas de carga, proporcionando información y optimizaciones que los métodos tradicionales pueden pasar por alto.

- Escalabilidad: El servidor está diseñado para manejar un gran número de usuarios concurrentes, lo que lo hace adecuado para probar aplicaciones de todos los tamaños.

- Monitoreo en Tiempo Real: Los usuarios pueden monitorear el rendimiento de sus aplicaciones en tiempo real durante las pruebas de carga, lo que permite retroalimentación y ajustes inmediatos.

- Escenarios Personalizables: Crea escenarios de pruebas de carga a medida que imitan el comportamiento real de los usuarios, asegurando que las pruebas sean relevantes y efectivas.

Cómo Usar el Servidor Locust MCP

- Instalación: Comienza instalando el Servidor Locust MCP en tu máquina o servidor. Sigue las instrucciones de instalación proporcionadas en la documentación.

- Configuración: Configura los ajustes del servidor para que coincidan con tus requisitos de prueba. Esto incluye establecer el número de usuarios, la duración de la prueba y cualquier escenario específico que desees simular.

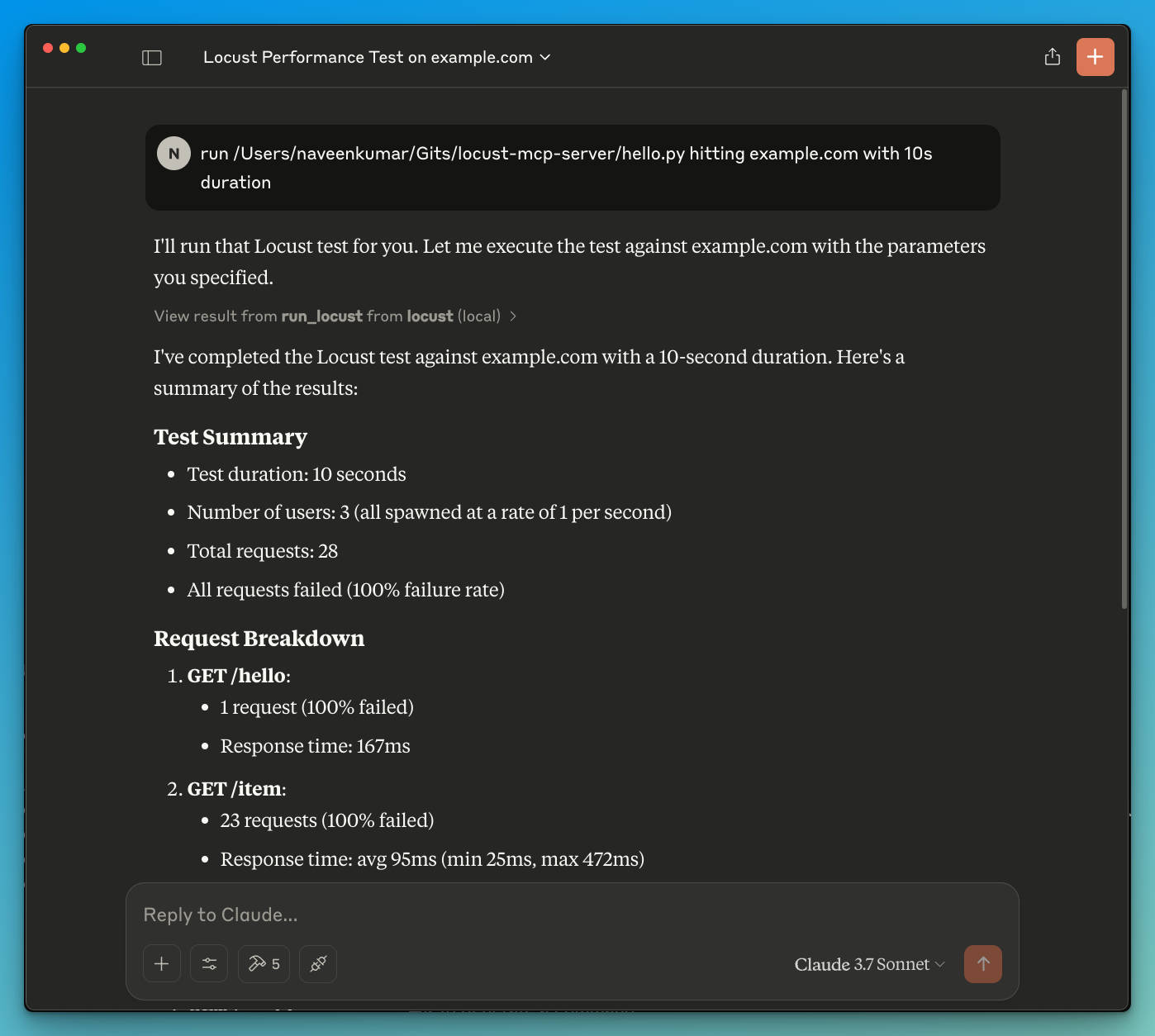

- Ejecutar Pruebas: Inicia las pruebas de carga a través de la interfaz del servidor. Monitorea el progreso y los resultados en tiempo real para obtener información sobre el rendimiento de tu aplicación.

- Analizar Resultados: Después de que las pruebas estén completas, analiza los resultados para identificar cuellos de botella, problemas de rendimiento y áreas de mejora.

- Iterar: Basado en los hallazgos, realiza los ajustes necesarios en tu aplicación y repite el proceso de prueba para asegurar un rendimiento óptimo.

Preguntas Frecuentes

P: ¿Cuál es el propósito principal del Servidor Locust MCP?

R: El propósito principal es facilitar pruebas de carga para aplicaciones, permitiendo a los desarrolladores simular tráfico de usuarios y evaluar el rendimiento bajo diversas condiciones.

P: ¿Puedo integrar el Servidor Locust MCP con otras herramientas?

R: Sí, el Servidor Locust MCP está diseñado para integrarse con varias herramientas de desarrollo y pruebas, mejorando su funcionalidad y usabilidad.

P: ¿Hay algún costo asociado con el uso del Servidor Locust MCP?

R: El Servidor Locust MCP es de código abierto y gratuito, lo que lo hace accesible para desarrolladores y organizaciones de todos los tamaños.

P: ¿Cómo puedo contribuir al proyecto del Servidor Locust MCP?

R: ¡Las contribuciones son bienvenidas! Puedes participar reportando problemas, sugiriendo características o enviando mejoras de código a través del repositorio del proyecto.

P: ¿Dónde puedo encontrar más información sobre el Servidor Locust MCP?

R: Para obtener información más detallada, documentación y soporte, visita el sitio web oficial en qainsights.com.

Detalle

Configuración del Servidor

{

"mcpServers": {

"locust-mcp-server": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--qainsights--locust-mcp-server--locust-mcp-server",

"python main.py"

],

"env": {}

}

}

}