🚀 ⚡️ Сервер Locust Mcp

Реализация сервера Model Context Protocol (MCP) для проведения нагрузочных тестов с помощью Locust. Этот сервер обеспечивает бесшовную интеграцию возможностей нагрузочного тестирования Locust с разработческими средами на базе ИИ.

Обзор

Что такое сервер Locust MCP?

Сервер ### Locust MCP - это специализированная реализация, предназначенная для упрощения нагрузочного тестирования с использованием Locust, популярного инструмента для нагрузочного тестирования с открытым исходным кодом. Этот сервер позволяет пользователям эффективно проводить нагрузочные тесты, интегрируя возможности Locust с разработкой на основе ИИ. Он предоставляет надежную основу для моделирования пользовательского трафика и измерения производительности системы в различных условиях, что делает его незаменимым инструментом для разработчиков и тестировщиков, стремящихся обеспечить, чтобы их приложения могли справляться с ожидаемыми нагрузками.

Особенности сервера Locust MCP

- Бесшовная интеграция: Сервер Locust MCP плавно интегрируется с существующими средами разработки, позволяя легко настраивать и выполнять нагрузочные тесты.

- Возможности на основе ИИ: Используйте технологии ИИ для улучшения стратегий нагрузочного тестирования, предоставляя инсайты и оптимизации, которые могут быть упущены традиционными методами.

- Масштабируемость: Сервер разработан для обработки большого количества одновременно работающих пользователей, что делает его подходящим для тестирования приложений любого размера.

- Мониторинг в реальном времени: Пользователи могут отслеживать производительность своих приложений в реальном времени во время нагрузочных тестов, что позволяет получать немедленную обратную связь и вносить корректировки.

- Настраиваемые сценарии: Создавайте индивидуальные сценарии нагрузочного тестирования, которые имитируют поведение реальных пользователей, обеспечивая актуальность и эффективность тестов.

Как использовать сервер Locust MCP

- Установка: Начните с установки сервера Locust MCP на своем компьютере или сервере. Следуйте инструкциям по установке, приведенным в документации.

- Конфигурация: Настройте параметры сервера в соответствии с вашими требованиями к тестированию. Это включает в себя настройку количества пользователей, продолжительности теста и любых конкретных сценариев, которые вы хотите смоделировать.

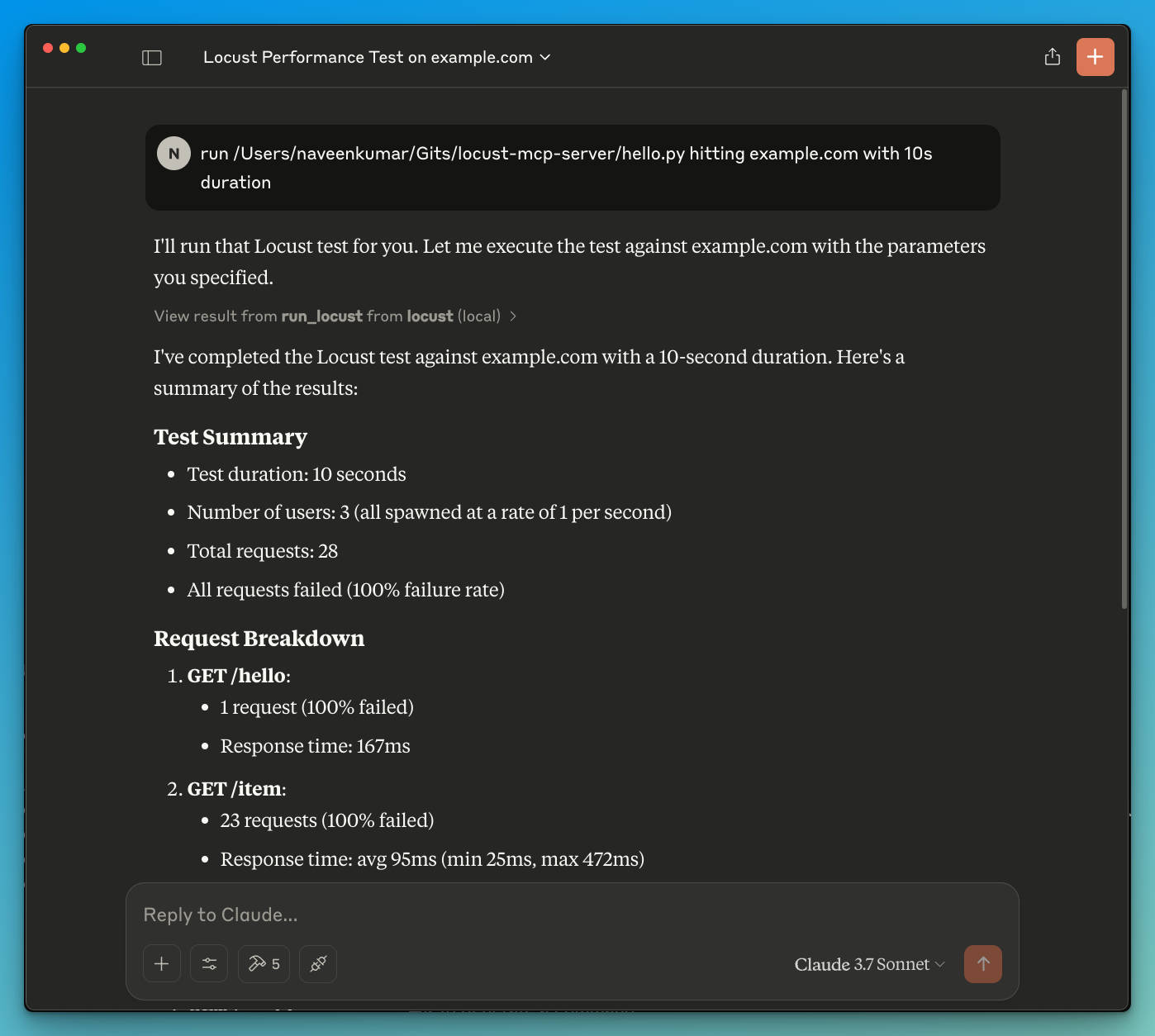

- Запуск тестов: Начните нагрузочные тесты через интерфейс сервера. Отслеживайте процесс и результаты в реальном времени, чтобы получить представление о производительности вашего приложения.

- Анализ результатов: После завершения тестов проанализируйте результаты, чтобы выявить узкие места, проблемы с производительностью и области для улучшения.

- Итерация: На основе полученных данных внесите необходимые корректировки в ваше приложение и повторите процесс тестирования, чтобы обеспечить оптимальную производительность.

Часто задаваемые вопросы

В: Какова основная цель сервера Locust MCP?

О: Основная цель - облегчить нагрузочное тестирование приложений, позволяя разработчикам моделировать пользовательский трафик и оценивать производительность в различных условиях.

В: Могу ли я интегрировать сервер Locust MCP с другими инструментами?

О: Да, сервер Locust MCP разработан для интеграции с различными инструментами разработки и тестирования, что улучшает его функциональность и удобство использования.

В: Есть ли стоимость, связанная с использованием сервера Locust MCP?

О: Сервер Locust MCP является открытым и бесплатным для использования, что делает его доступным для разработчиков и организаций любого размера.

В: Как я могу внести свой вклад в проект сервера Locust MCP?

О: Внесение вкладов приветствуется! Вы можете участвовать, сообщая о проблемах, предлагая функции или отправляя улучшения кода через репозиторий проекта.

В: Где я могу найти больше информации о сервере Locust MCP?

О: Для получения более подробной информации, документации и поддержки посетите официальный сайт по адресу qainsights.com.

Деталь

Конфигурация сервера

{

"mcpServers": {

"locust-mcp-server": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--qainsights--locust-mcp-server--locust-mcp-server",

"python main.py"

],

"env": {}

}

}

}