🚀 ⚡️ Servidor Locust Mcp

Uma implementação de servidor do Protocolo de Contexto de Modelo (MCP) para executar testes de carga com Locust. Este servidor permite a integração perfeita das capacidades de teste de carga do Locust com ambientes de desenvolvimento impulsionados por IA.

Visão geral

O que é o Servidor Locust MCP?

O ### Servidor Locust MCP é uma implementação especializada projetada para facilitar testes de carga usando o Locust, uma ferramenta de teste de carga de código aberto popular. Este servidor permite que os usuários realizem testes de carga de forma eficiente, integrando as capacidades do Locust com ambientes de desenvolvimento impulsionados por IA. Ele fornece uma estrutura robusta para simular o tráfego de usuários e medir o desempenho do sistema sob várias condições, tornando-se uma ferramenta essencial para desenvolvedores e testadores que buscam garantir que suas aplicações possam lidar com as cargas esperadas.

Recursos do Servidor Locust MCP

- Integração Sem Costura: O Servidor Locust MCP se integra suavemente com ambientes de desenvolvimento existentes, permitindo uma configuração e execução fáceis de testes de carga.

- Capacidades Impulsionadas por IA: Aproveite as tecnologias de IA para aprimorar as estratégias de teste de carga, fornecendo insights e otimizações que métodos tradicionais podem negligenciar.

- Escalabilidade: O servidor é projetado para lidar com um grande número de usuários simultâneos, tornando-o adequado para testar aplicações de todos os tamanhos.

- Monitoramento em Tempo Real: Os usuários podem monitorar o desempenho de suas aplicações em tempo real durante os testes de carga, permitindo feedback e ajustes imediatos.

- Cenários Personalizáveis: Crie cenários de teste de carga sob medida que imitam o comportamento real dos usuários, garantindo que os testes sejam relevantes e eficazes.

Como Usar o Servidor Locust MCP

- Instalação: Comece instalando o Servidor Locust MCP em sua máquina ou servidor. Siga as instruções de instalação fornecidas na documentação.

- Configuração: Configure as definições do servidor para corresponder aos seus requisitos de teste. Isso inclui configurar o número de usuários, a duração do teste e quaisquer cenários específicos que você deseja simular.

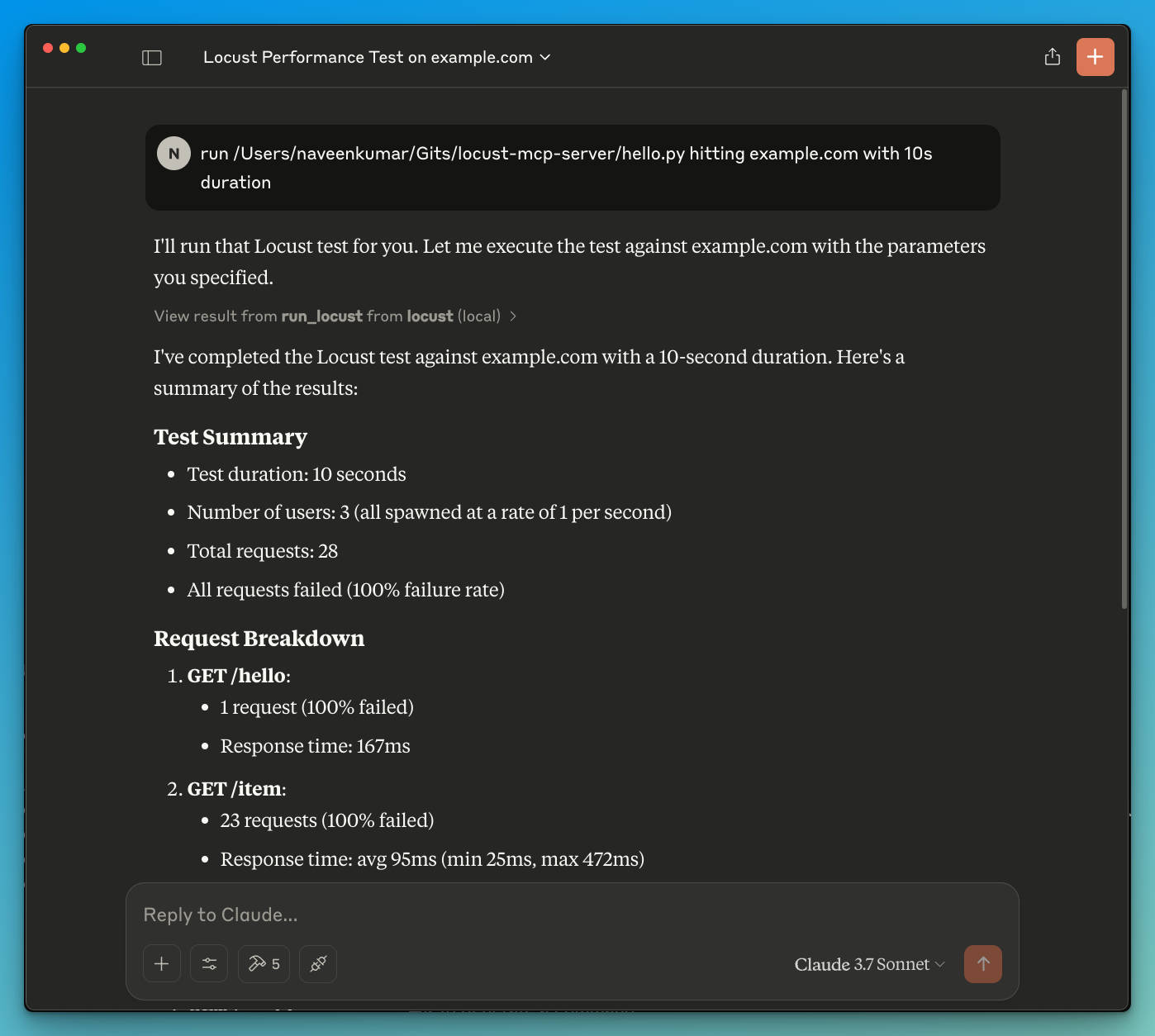

- Executar Testes: Inicie os testes de carga através da interface do servidor. Monitore o progresso e os resultados em tempo real para obter insights sobre o desempenho da sua aplicação.

- Analisar Resultados: Após a conclusão dos testes, analise os resultados para identificar gargalos, problemas de desempenho e áreas para melhoria.

- Iterar: Com base nas descobertas, faça os ajustes necessários em sua aplicação e repita o processo de teste para garantir um desempenho ideal.

Perguntas Frequentes

Q: Qual é o principal objetivo do Servidor Locust MCP?

A: O principal objetivo é facilitar testes de carga para aplicações, permitindo que os desenvolvedores simulem o tráfego de usuários e avaliem o desempenho sob várias condições.

Q: Posso integrar o Servidor Locust MCP com outras ferramentas?

A: Sim, o Servidor Locust MCP foi projetado para se integrar a várias ferramentas de desenvolvimento e teste, aprimorando sua funcionalidade e usabilidade.

Q: Há algum custo associado ao uso do Servidor Locust MCP?

A: O Servidor Locust MCP é de código aberto e gratuito para uso, tornando-o acessível para desenvolvedores e organizações de todos os tamanhos.

Q: Como posso contribuir para o projeto do Servidor Locust MCP?

A: Contribuições são bem-vindas! Você pode participar relatando problemas, sugerindo recursos ou enviando melhorias de código através do repositório do projeto.

Q: Onde posso encontrar mais informações sobre o Servidor Locust MCP?

A: Para informações mais detalhadas, documentação e suporte, visite o site oficial em qainsights.com.

Detalhe

Configuração do Servidor

{

"mcpServers": {

"locust-mcp-server": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--qainsights--locust-mcp-server--locust-mcp-server",

"python main.py"

],

"env": {}

}

}

}