🚀 ⚡️ Server Mcp Locust

Un'implementazione del server del Protocollo di Contesto del Modello (MCP) per eseguire test di carico con Locust. Questo server consente un'integrazione fluida delle capacità di test di carico di Locust con ambienti di sviluppo potenziati dall'IA.

Panoramica

Cos'è il Server Locust MCP?

Il ### Server Locust MCP è un'implementazione specializzata progettata per facilitare il load testing utilizzando Locust, un popolare strumento open-source per il load testing. Questo server consente agli utenti di eseguire test di carico in modo efficiente integrando le capacità di Locust con ambienti di sviluppo potenziati dall'IA. Fornisce un framework robusto per simulare il traffico degli utenti e misurare le prestazioni del sistema in diverse condizioni, rendendolo uno strumento essenziale per sviluppatori e tester che mirano a garantire che le loro applicazioni possano gestire i carichi previsti.

Caratteristiche del Server Locust MCP

- Integrazione senza soluzione di continuità: Il Server Locust MCP si integra facilmente con gli ambienti di sviluppo esistenti, consentendo una configurazione e un'esecuzione semplici dei test di carico.

- Capacità potenziate dall'IA: Sfrutta le tecnologie IA per migliorare le strategie di load testing, fornendo approfondimenti e ottimizzazioni che i metodi tradizionali potrebbero trascurare.

- Scalabilità: Il server è progettato per gestire un gran numero di utenti contemporanei, rendendolo adatto per testare applicazioni di tutte le dimensioni.

- Monitoraggio in tempo reale: Gli utenti possono monitorare le prestazioni delle loro applicazioni in tempo reale durante i test di carico, consentendo feedback e aggiustamenti immediati.

- Scenari personalizzabili: Crea scenari di load testing su misura che imitano il comportamento reale degli utenti, assicurando che i test siano pertinenti ed efficaci.

Come utilizzare il Server Locust MCP

- Installazione: Inizia installando il Server Locust MCP sul tuo computer o server. Segui le istruzioni di installazione fornite nella documentazione.

- Configurazione: Configura le impostazioni del server per soddisfare i tuoi requisiti di test. Questo include impostare il numero di utenti, la durata del test e eventuali scenari specifici che desideri simulare.

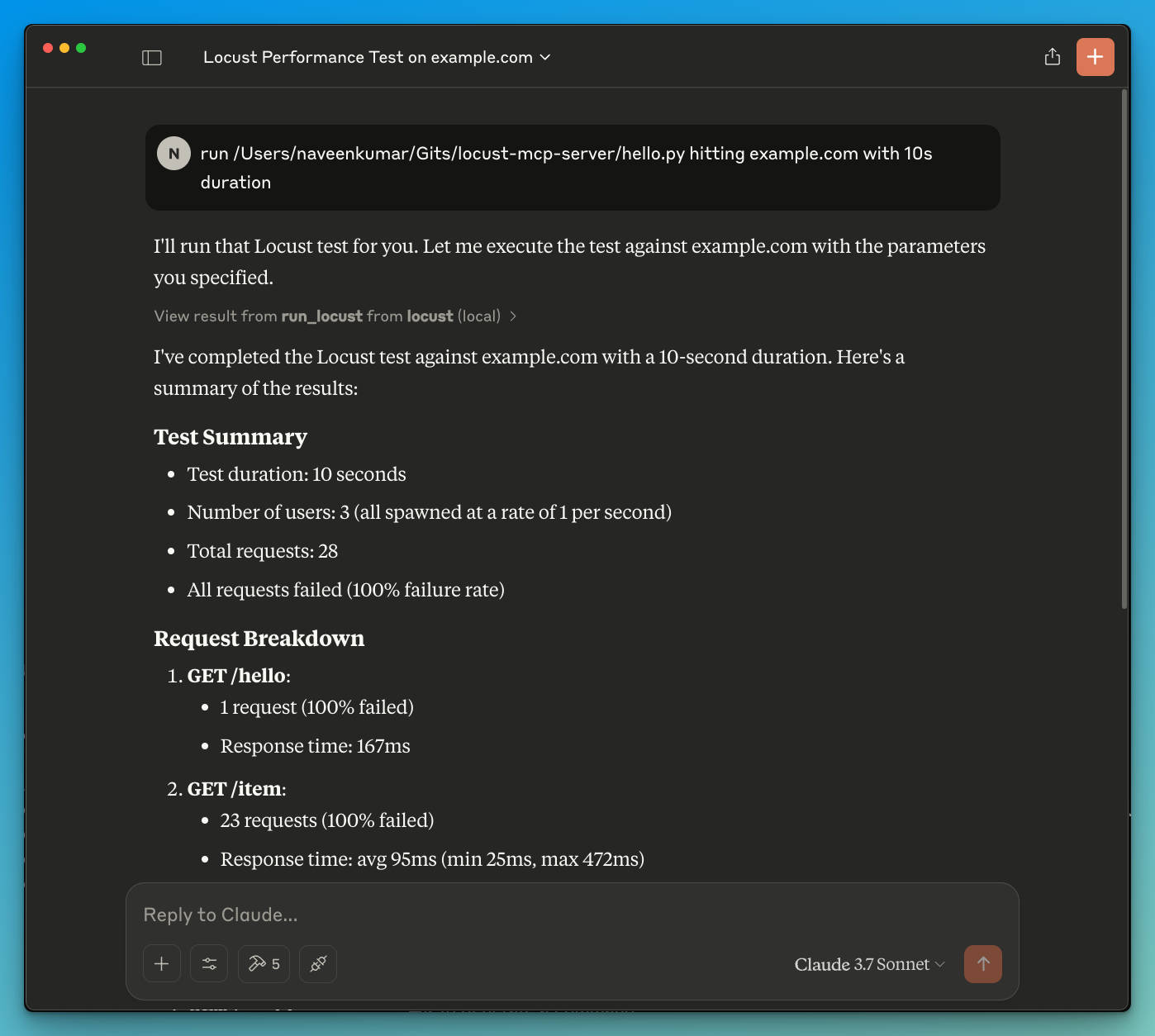

- Esegui i test: Avvia i test di carico tramite l'interfaccia del server. Monitora i progressi e i risultati in tempo reale per ottenere approfondimenti sulle prestazioni della tua applicazione.

- Analizza i risultati: Dopo il completamento dei test, analizza i risultati per identificare colli di bottiglia, problemi di prestazioni e aree di miglioramento.

- Itera: Sulla base dei risultati, apporta le necessarie modifiche alla tua applicazione e ripeti il processo di testing per garantire prestazioni ottimali.

Domande Frequenti

D: Qual è lo scopo principale del Server Locust MCP?

R: Lo scopo principale è facilitare il load testing per le applicazioni, consentendo agli sviluppatori di simulare il traffico degli utenti e valutare le prestazioni in diverse condizioni.

D: Posso integrare il Server Locust MCP con altri strumenti?

R: Sì, il Server Locust MCP è progettato per integrarsi con vari strumenti di sviluppo e testing, migliorando la sua funzionalità e usabilità.

D: C'è un costo associato all'uso del Server Locust MCP?

R: Il Server Locust MCP è open-source e gratuito da usare, rendendolo accessibile per sviluppatori e organizzazioni di tutte le dimensioni.

D: Come posso contribuire al progetto del Server Locust MCP?

R: I contributi sono benvenuti! Puoi partecipare segnalando problemi, suggerendo funzionalità o inviando miglioramenti del codice attraverso il repository del progetto.

D: Dove posso trovare ulteriori informazioni sul Server Locust MCP?

R: Per ulteriori informazioni dettagliate, documentazione e supporto, visita il sito ufficiale su qainsights.com.

Dettaglio

Configurazione Server

{

"mcpServers": {

"locust-mcp-server": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--qainsights--locust-mcp-server--locust-mcp-server",

"python main.py"

],

"env": {}

}

}

}