Qualquer Conclusões de Chat Mcp Servidor Mcp

Servidor MCP para usar qualquer LLM como uma Ferramenta

Visão geral

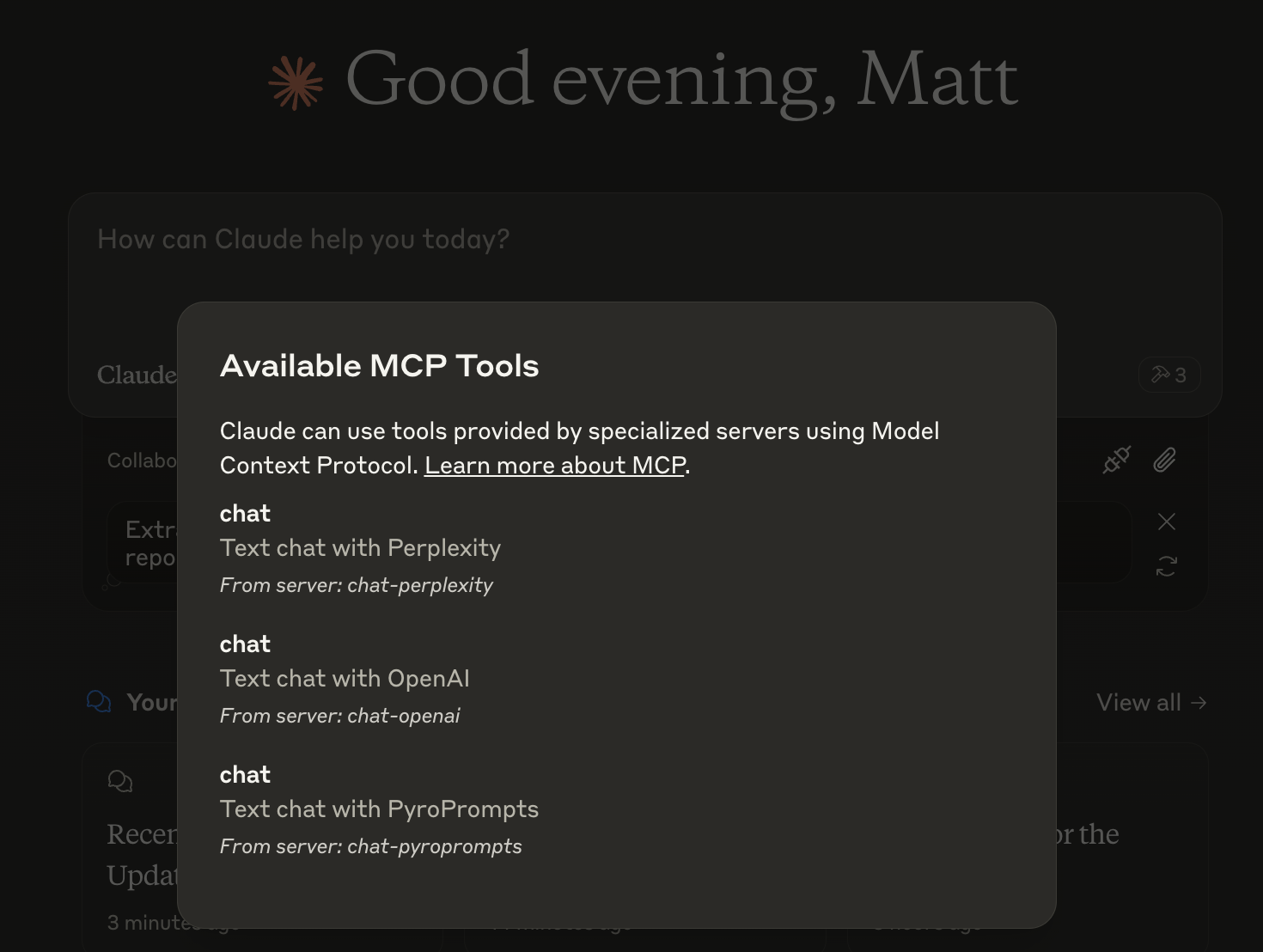

O que é Any Chat Completions MCP?

Any Chat Completions MCP é um servidor versátil projetado para utilizar qualquer Modelo de Linguagem Grande (LLM) como uma ferramenta. Esta plataforma inovadora permite que desenvolvedores e usuários integrem vários LLMs em suas aplicações, aprimorando as capacidades de chatbots e outras interfaces conversacionais. Ao aproveitar o poder dos LLMs, os usuários podem criar interações mais envolventes e inteligentes, tornando-se um recurso valioso para empresas e desenvolvedores.

Recursos do Any Chat Completions MCP

- Suporte a Múltiplos LLMs: O servidor suporta vários LLMs, permitindo que os usuários escolham o melhor modelo para suas necessidades específicas.

- Integração Fácil: Com uma API simples, os desenvolvedores podem integrar facilmente o servidor em suas aplicações existentes.

- Escalabilidade: A arquitetura é projetada para lidar com um grande número de solicitações, tornando-a adequada tanto para pequenos projetos quanto para aplicações em grande escala.

- Personalizável: Os usuários podem personalizar o comportamento dos LLMs para atender a seus casos de uso específicos, melhorando a experiência do usuário.

- Código Aberto: Sendo um projeto de código aberto, ele incentiva contribuições da comunidade e transparência.

Como Usar o Any Chat Completions MCP

- Instalação: Comece clonando o repositório do GitHub e instalando as dependências necessárias.

- Configuração: Configure seu ambiente ajustando as configurações do servidor para especificar quais LLMs você deseja usar.

- Integração da API: Use os endpoints da API fornecidos para enviar solicitações ao servidor e receber respostas dos LLMs.

- Testes: Teste a integração em um ambiente de desenvolvimento para garantir que tudo esteja funcionando como esperado.

- Implantação: Após os testes, implante o servidor em seu ambiente de produção e comece a utilizar os LLMs em suas aplicações.

Perguntas Frequentes

Q: Qual é o principal caso de uso do Any Chat Completions MCP?

A: O principal caso de uso é aprimorar chatbots e interfaces conversacionais integrando vários LLMs, permitindo interações mais inteligentes e envolventes.

Q: O Any Chat Completions MCP é gratuito para usar?

A: Sim, é um projeto de código aberto, o que significa que é gratuito para usar e modificar.

Q: Posso contribuir para o projeto?

A: Absolutamente! Contribuições são bem-vindas. Você pode enviar problemas, solicitações de recursos ou pull requests no repositório do GitHub.

Q: Quais linguagens de programação são suportadas?

A: O servidor é projetado para ser independente de linguagem, mas a API pode ser facilmente acessada usando linguagens de programação populares como Python, JavaScript e Java.

Q: Como posso relatar problemas ou bugs?

A: Você pode relatar problemas ou bugs criando uma issue no repositório do GitHub, fornecendo detalhes sobre o problema que encontrou.

Ao utilizar o Any Chat Completions MCP, os desenvolvedores podem aprimorar significativamente as capacidades conversacionais de suas aplicações, tornando-o uma ferramenta poderosa no campo da IA e aprendizado de máquina.

Detalhe

Configuração do Servidor

{

"mcpServers": {

"any-chat-completions-mcp": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--pyroprompts--any-chat-completions-mcp--any-chat-completions-mcp",

"npm run start"

],

"env": {

"AI_CHAT_KEY": "ai-chat-key",

"AI_CHAT_NAME": "ai-chat-name",

"AI_CHAT_MODEL": "ai-chat-model",

"AI_CHAT_BASE_URL": "ai-chat-base-url"

}

}

}

}