Toute complétion de chat Mcp Serveur Mcp

Serveur MCP pour utiliser n'importe quel LLM comme outil

Aperçu

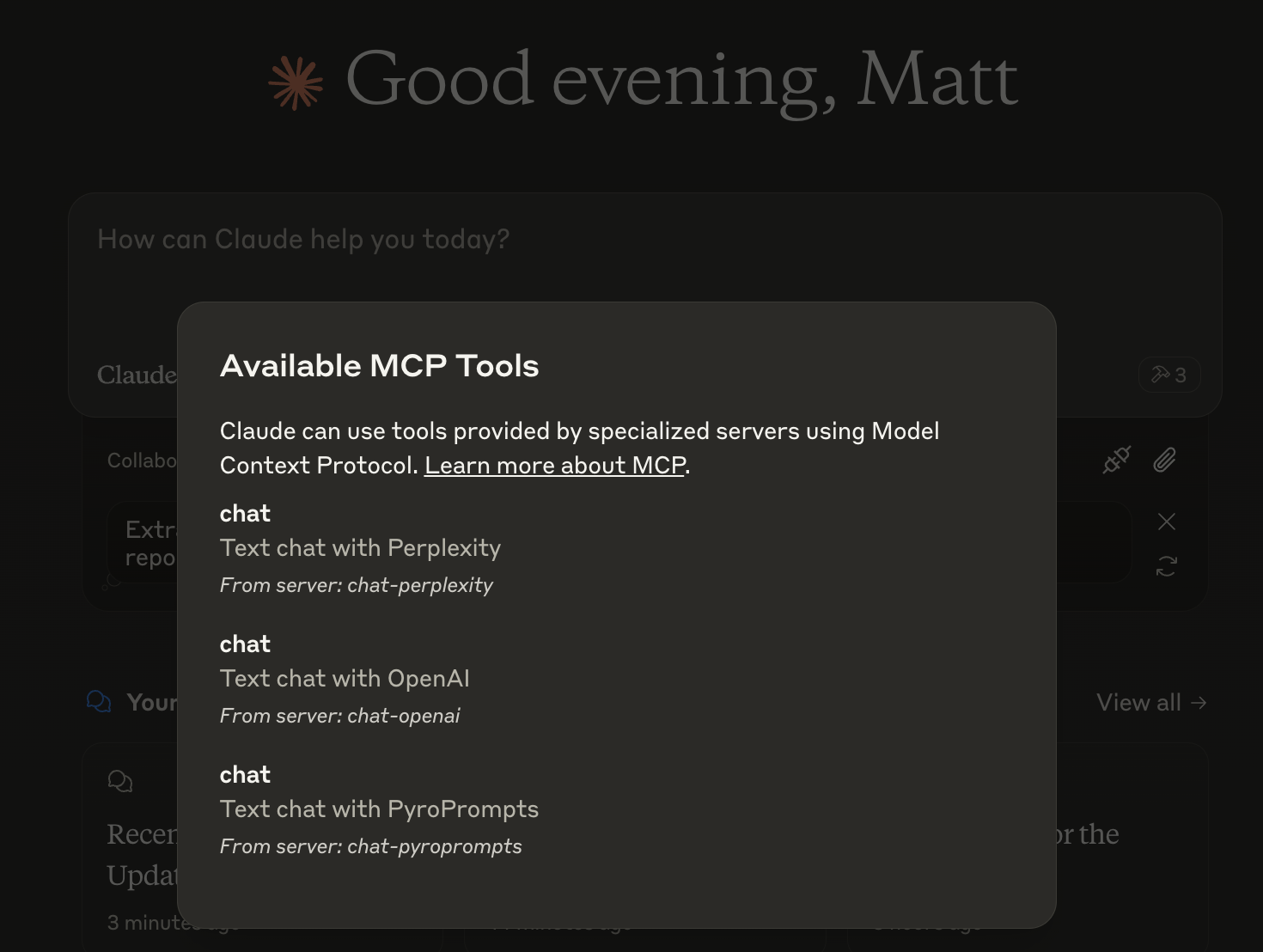

Qu'est-ce que Any Chat Completions MCP ?

Any Chat Completions MCP est un serveur polyvalent conçu pour utiliser n'importe quel Modèle de Langage de Grande Taille (LLM) comme outil. Cette plateforme innovante permet aux développeurs et aux utilisateurs d'intégrer divers LLM dans leurs applications, améliorant ainsi les capacités des chatbots et d'autres interfaces conversationnelles. En tirant parti de la puissance des LLM, les utilisateurs peuvent créer des interactions plus engageantes et intelligentes, ce qui en fait une ressource précieuse pour les entreprises et les développeurs.

Fonctionnalités de Any Chat Completions MCP

- Support Multi-LLM : Le serveur prend en charge plusieurs LLM, permettant aux utilisateurs de choisir le meilleur modèle pour leurs besoins spécifiques.

- Intégration Facile : Avec une API simple, les développeurs peuvent facilement intégrer le serveur dans leurs applications existantes.

- Scalabilité : L'architecture est conçue pour gérer un grand nombre de requêtes, ce qui la rend adaptée aux petits projets comme aux applications à grande échelle.

- Personnalisable : Les utilisateurs peuvent personnaliser le comportement des LLM pour s'adapter à leurs cas d'utilisation spécifiques, améliorant ainsi l'expérience utilisateur.

- Open Source : En tant que projet open-source, il encourage les contributions de la communauté et la transparence.

Comment utiliser Any Chat Completions MCP

- Installation : Commencez par cloner le dépôt depuis GitHub et installer les dépendances nécessaires.

- Configuration : Configurez votre environnement en paramétrant les réglages du serveur pour spécifier quels LLM vous souhaitez utiliser.

- Intégration API : Utilisez les points de terminaison API fournis pour envoyer des requêtes au serveur et recevoir des réponses des LLM.

- Test : Testez l'intégration dans un environnement de développement pour vous assurer que tout fonctionne comme prévu.

- Déploiement : Une fois testé, déployez le serveur dans votre environnement de production et commencez à utiliser les LLM dans vos applications.

Questions Fréquemment Posées

Q : Quel est le cas d'utilisation principal de Any Chat Completions MCP ?

R : Le cas d'utilisation principal est d'améliorer les chatbots et les interfaces conversationnelles en intégrant divers LLM, permettant des interactions plus intelligentes et engageantes.

Q : Any Chat Completions MCP est-il gratuit à utiliser ?

R : Oui, c'est un projet open-source, ce qui signifie qu'il est gratuit à utiliser et à modifier.

Q : Puis-je contribuer au projet ?

R : Absolument ! Les contributions sont les bienvenues. Vous pouvez soumettre des problèmes, des demandes de fonctionnalités ou des demandes de tirage sur le dépôt GitHub.

Q : Quels langages de programmation sont pris en charge ?

R : Le serveur est conçu pour être indépendant du langage, mais l'API peut être facilement accessible en utilisant des langages de programmation populaires comme Python, JavaScript et Java.

Q : Comment signaler des problèmes ou des bugs ?

R : Vous pouvez signaler des problèmes ou des bugs en créant un problème sur le dépôt GitHub, en fournissant des détails sur le problème que vous avez rencontré.

En utilisant Any Chat Completions MCP, les développeurs peuvent considérablement améliorer les capacités conversationnelles de leurs applications, en faisant un outil puissant dans le domaine de l'IA et de l'apprentissage automatique.

Détail

Configuration du serveur

{

"mcpServers": {

"any-chat-completions-mcp": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--pyroprompts--any-chat-completions-mcp--any-chat-completions-mcp",

"npm run start"

],

"env": {

"AI_CHAT_KEY": "ai-chat-key",

"AI_CHAT_NAME": "ai-chat-name",

"AI_CHAT_MODEL": "ai-chat-model",

"AI_CHAT_BASE_URL": "ai-chat-base-url"

}

}

}

}