任意のチャット完了 Mcp Mcp サーバー

概要

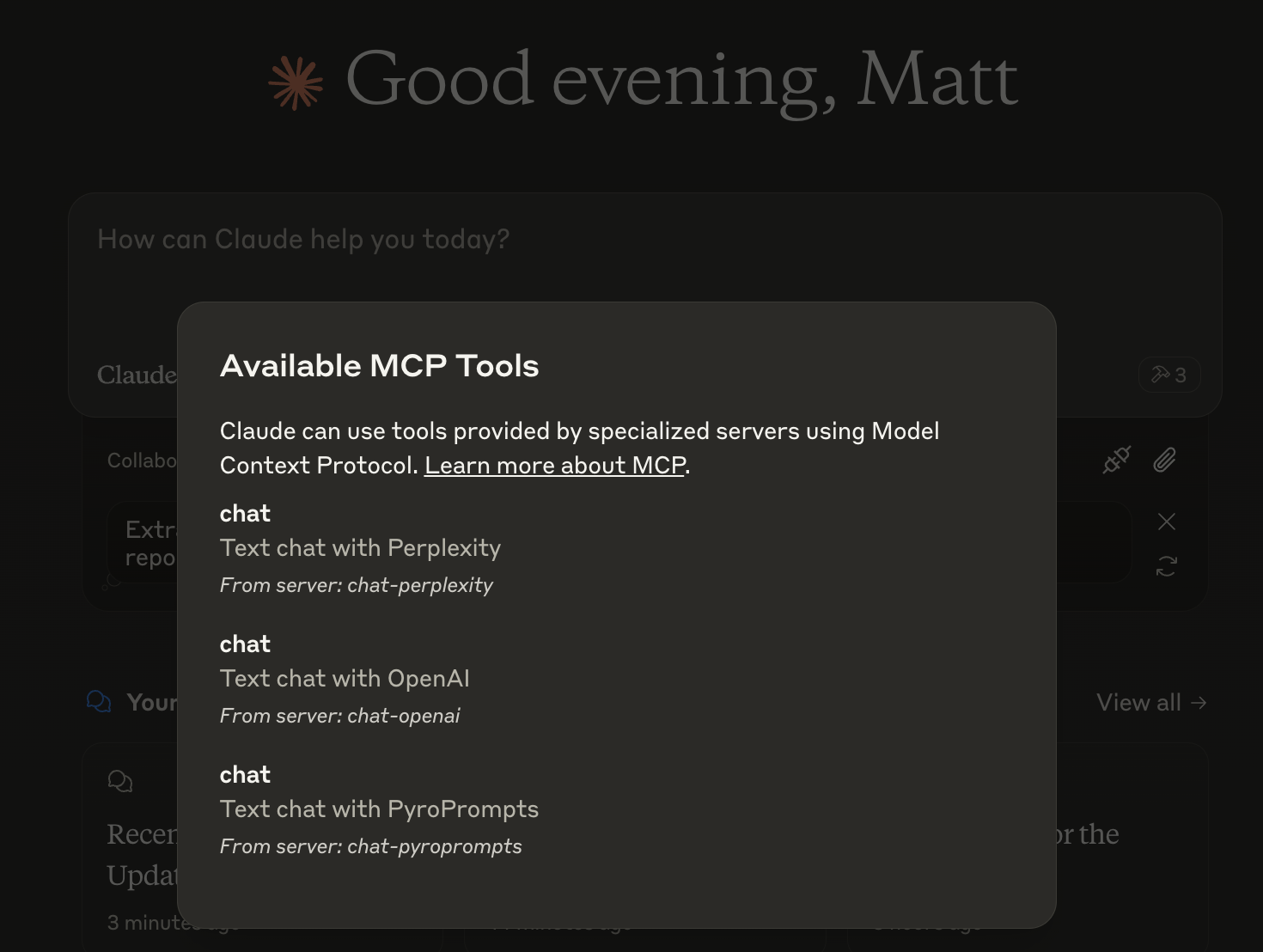

Any Chat Completions MCPとは?

Any Chat Completions MCPは、あらゆる大規模言語モデル(LLM)をツールとして利用するために設計された多目的サーバーです。この革新的なプラットフォームは、開発者やユーザーがさまざまなLLMをアプリケーションに統合できるようにし、チャットボットやその他の会話インターフェースの機能を向上させます。LLMの力を活用することで、ユーザーはより魅力的で知的なインタラクションを作成でき、ビジネスや開発者にとって貴重なリソースとなります。

Any Chat Completions MCPの特徴

- マルチLLMサポート:サーバーは複数のLLMをサポートしており、ユーザーは特定のニーズに最適なモデルを選択できます。

- 簡単な統合:シンプルなAPIを使用することで、開発者は既存のアプリケーションにサーバーを簡単に統合できます。

- スケーラビリティ:アーキテクチャは大量のリクエストを処理できるように設計されており、小規模プロジェクトから大規模アプリケーションまで適しています。

- カスタマイズ可能:ユーザーは特定のユースケースに合わせてLLMの動作をカスタマイズでき、ユーザー体験を向上させます。

- オープンソース:オープンソースプロジェクトであるため、コミュニティの貢献と透明性を促進します。

Any Chat Completions MCPの使い方

- インストール:まず、GitHubからリポジトリをクローンし、必要な依存関係をインストールします。

- 設定:サーバー設定を構成して、使用したいLLMを指定することで環境をセットアップします。

- API統合:提供されたAPIエンドポイントを使用して、サーバーにリクエストを送信し、LLMからのレスポンスを受け取ります。

- テスト:開発環境で統合をテストして、すべてが期待通りに機能していることを確認します。

- デプロイ:テストが完了したら、サーバーを本番環境にデプロイし、アプリケーションでLLMを利用し始めます。

よくある質問

Q: Any Chat Completions MCPの主な使用ケースは何ですか?

A: 主な使用ケースは、さまざまなLLMを統合することでチャットボットや会話インターフェースを強化し、より知的で魅力的なインタラクションを可能にすることです。

Q: Any Chat Completions MCPは無料で使用できますか?

A: はい、これはオープンソースプロジェクトであり、無料で使用および変更できます。

Q: プロジェクトに貢献できますか?

A: もちろんです!貢献は歓迎されます。GitHubリポジトリで問題、機能リクエスト、またはプルリクエストを提出できます。

Q: どのプログラミング言語がサポートされていますか?

A: サーバーは言語に依存しないように設計されていますが、APIはPython、JavaScript、Javaなどの人気のあるプログラミング言語を使用して簡単にアクセスできます。

Q: 問題やバグを報告するにはどうすればよいですか?

A: GitHubリポジトリで問題を作成し、遭遇した問題の詳細を提供することで、問題やバグを報告できます。

Any Chat Completions MCPを利用することで、開発者はアプリケーションの会話能力を大幅に向上させることができ、AIや機械学習の分野で強力なツールとなります。

詳細

サーバー設定

{

"mcpServers": {

"any-chat-completions-mcp": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--pyroprompts--any-chat-completions-mcp--any-chat-completions-mcp",

"npm run start"

],

"env": {

"AI_CHAT_KEY": "ai-chat-key",

"AI_CHAT_NAME": "ai-chat-name",

"AI_CHAT_MODEL": "ai-chat-model",

"AI_CHAT_BASE_URL": "ai-chat-base-url"

}

}

}

}