Cualquier finalización de chat Mcp Servidor Mcp

Servidor MCP para usar cualquier LLM como herramienta

Resumen

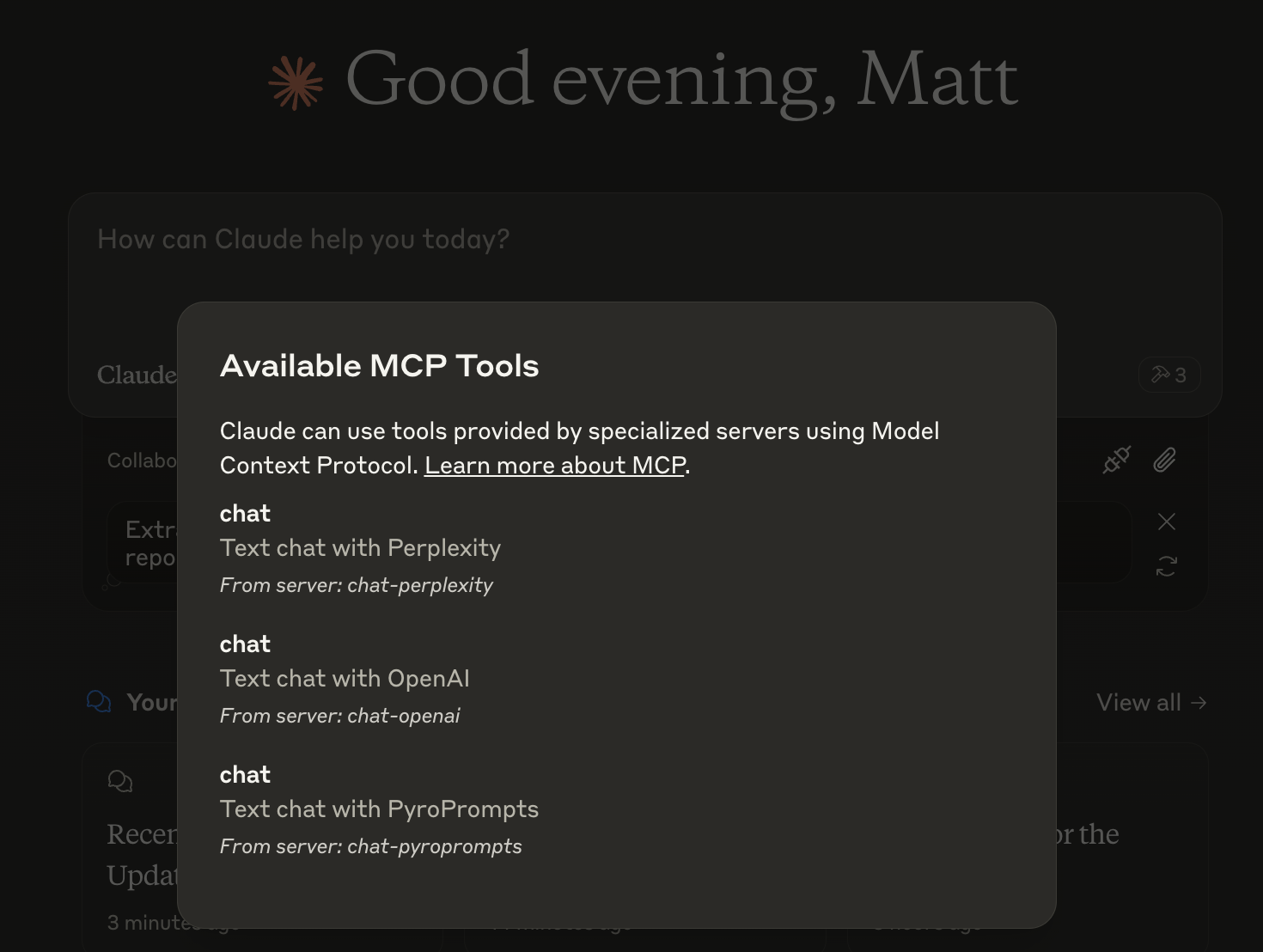

¿Qué es Any Chat Completions MCP?

Any Chat Completions MCP es un servidor versátil diseñado para utilizar cualquier Modelo de Lenguaje Grande (LLM) como herramienta. Esta plataforma innovadora permite a desarrolladores y usuarios integrar varios LLM en sus aplicaciones, mejorando las capacidades de chatbots y otras interfaces conversacionales. Al aprovechar el poder de los LLM, los usuarios pueden crear interacciones más atractivas e inteligentes, convirtiéndolo en un recurso valioso para empresas y desarrolladores por igual.

Características de Any Chat Completions MCP

- Soporte Multi-LLM: El servidor soporta múltiples LLM, permitiendo a los usuarios elegir el mejor modelo para sus necesidades específicas.

- Integración Fácil: Con una API sencilla, los desarrolladores pueden integrar fácilmente el servidor en sus aplicaciones existentes.

- Escalabilidad: La arquitectura está diseñada para manejar un gran número de solicitudes, lo que la hace adecuada tanto para proyectos pequeños como para aplicaciones a gran escala.

- Personalizable: Los usuarios pueden personalizar el comportamiento de los LLM para adaptarse a sus casos de uso específicos, mejorando la experiencia del usuario.

- Código Abierto: Al ser un proyecto de código abierto, fomenta las contribuciones de la comunidad y la transparencia.

Cómo Usar Any Chat Completions MCP

- Instalación: Comienza clonando el repositorio desde GitHub e instalando las dependencias necesarias.

- Configuración: Configura tu entorno ajustando la configuración del servidor para especificar qué LLM deseas utilizar.

- Integración de API: Utiliza los puntos finales de API proporcionados para enviar solicitudes al servidor y recibir respuestas de los LLM.

- Pruebas: Prueba la integración en un entorno de desarrollo para asegurarte de que todo funcione como se espera.

- Despliegue: Una vez probado, despliega el servidor en tu entorno de producción y comienza a utilizar los LLM en tus aplicaciones.

Preguntas Frecuentes

P: ¿Cuál es el caso de uso principal de Any Chat Completions MCP?

R: El caso de uso principal es mejorar chatbots e interfaces conversacionales integrando varios LLM, permitiendo interacciones más inteligentes y atractivas.

P: ¿Es Any Chat Completions MCP gratuito para usar?

R: Sí, es un proyecto de código abierto, lo que significa que es gratuito para usar y modificar.

P: ¿Puedo contribuir al proyecto?

R: ¡Absolutamente! Las contribuciones son bienvenidas. Puedes enviar problemas, solicitudes de características o solicitudes de extracción en el repositorio de GitHub.

P: ¿Qué lenguajes de programación son compatibles?

R: El servidor está diseñado para ser independiente del lenguaje, pero la API se puede acceder fácilmente utilizando lenguajes de programación populares como Python, JavaScript y Java.

P: ¿Cómo informo sobre problemas o errores?

R: Puedes informar sobre problemas o errores creando un problema en el repositorio de GitHub, proporcionando detalles sobre el problema que encontraste.

Al utilizar Any Chat Completions MCP, los desarrolladores pueden mejorar significativamente las capacidades conversacionales de sus aplicaciones, convirtiéndolo en una herramienta poderosa en el ámbito de la IA y el aprendizaje automático.

Detalle

Configuración del Servidor

{

"mcpServers": {

"any-chat-completions-mcp": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--pyroprompts--any-chat-completions-mcp--any-chat-completions-mcp",

"npm run start"

],

"env": {

"AI_CHAT_KEY": "ai-chat-key",

"AI_CHAT_NAME": "ai-chat-name",

"AI_CHAT_MODEL": "ai-chat-model",

"AI_CHAT_BASE_URL": "ai-chat-base-url"

}

}

}

}