Alle Chat-Vervollständigungen Mcp Mcp-Server

MCP-Server zur Verwendung von beliebigen LLM als Werkzeug

Übersicht

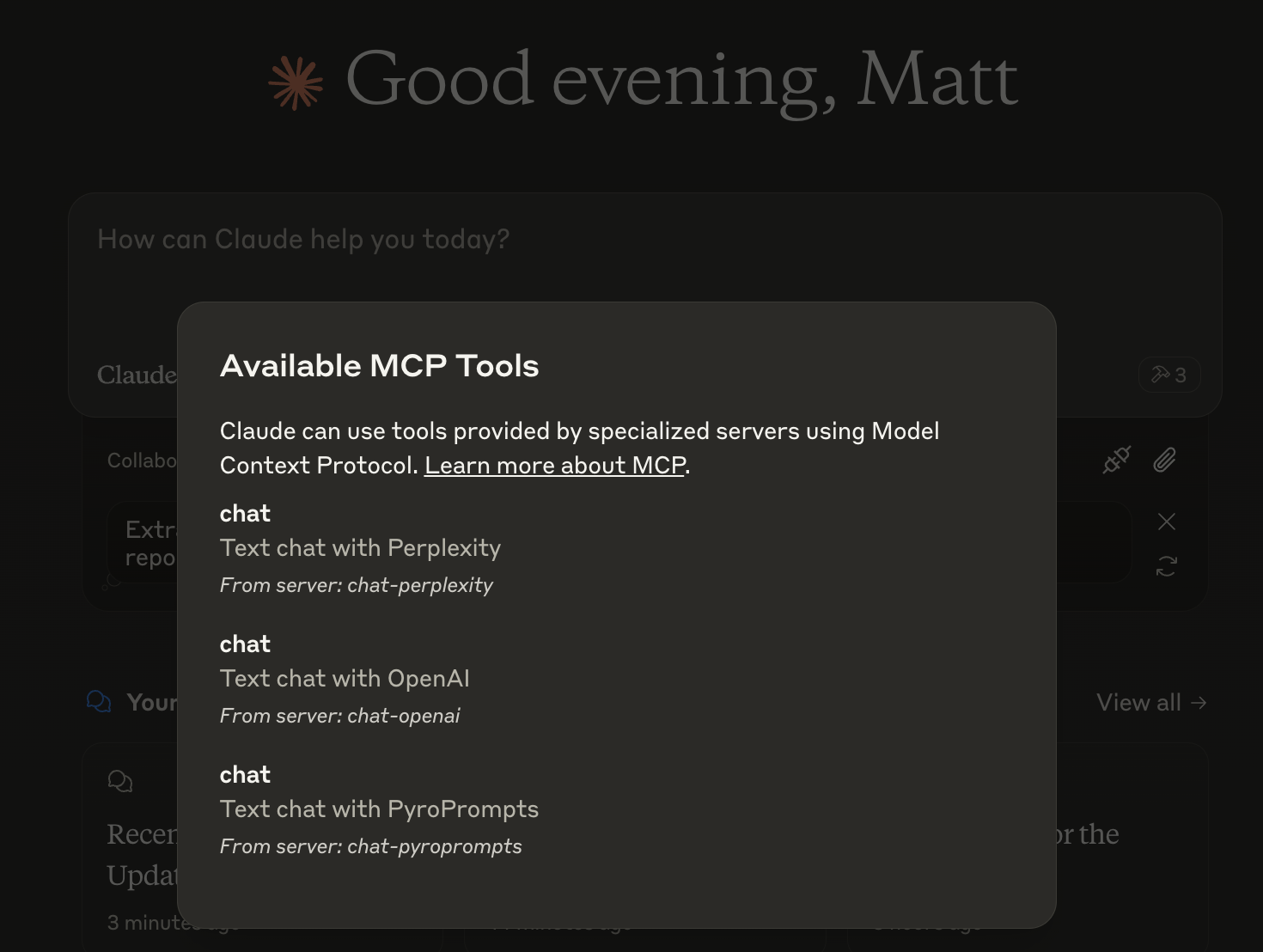

Was ist Any Chat Completions MCP?

Any Chat Completions MCP ist ein vielseitiger Server, der entwickelt wurde, um jedes große Sprachmodell (LLM) als Werkzeug zu nutzen. Diese innovative Plattform ermöglicht es Entwicklern und Nutzern, verschiedene LLMs in ihre Anwendungen zu integrieren, wodurch die Fähigkeiten von Chatbots und anderen Konversationsschnittstellen verbessert werden. Durch die Nutzung der Leistungsfähigkeit von LLMs können Nutzer ansprechendere und intelligentere Interaktionen schaffen, was es zu einer wertvollen Ressource für Unternehmen und Entwickler macht.

Funktionen von Any Chat Completions MCP

- Multi-LLM-Unterstützung: Der Server unterstützt mehrere LLMs, sodass Nutzer das beste Modell für ihre spezifischen Bedürfnisse auswählen können.

- Einfache Integration: Mit einer unkomplizierten API können Entwickler den Server problemlos in ihre bestehenden Anwendungen integrieren.

- Skalierbarkeit: Die Architektur ist so gestaltet, dass sie eine große Anzahl von Anfragen verarbeiten kann, was sie sowohl für kleine Projekte als auch für großangelegte Anwendungen geeignet macht.

- Anpassbar: Nutzer können das Verhalten der LLMs an ihre spezifischen Anwendungsfälle anpassen, um das Benutzererlebnis zu verbessern.

- Open Source: Als Open-Source-Projekt fördert es Gemeinschaftsbeiträge und Transparenz.

So verwenden Sie Any Chat Completions MCP

- Installation: Beginnen Sie damit, das Repository von GitHub zu klonen und die erforderlichen Abhängigkeiten zu installieren.

- Konfiguration: Richten Sie Ihre Umgebung ein, indem Sie die Servereinstellungen konfigurieren, um festzulegen, welche LLMs Sie verwenden möchten.

- API-Integration: Verwenden Sie die bereitgestellten API-Endpunkte, um Anfragen an den Server zu senden und Antworten von den LLMs zu erhalten.

- Testen: Testen Sie die Integration in einer Entwicklungsumgebung, um sicherzustellen, dass alles wie erwartet funktioniert.

- Bereitstellung: Nach dem Testen stellen Sie den Server in Ihrer Produktionsumgebung bereit und beginnen, die LLMs in Ihren Anwendungen zu nutzen.

Häufig gestellte Fragen

F: Was ist der Hauptanwendungsfall für Any Chat Completions MCP?

A: Der Hauptanwendungsfall besteht darin, Chatbots und Konversationsschnittstellen zu verbessern, indem verschiedene LLMs integriert werden, was intelligentere und ansprechendere Interaktionen ermöglicht.

F: Ist Any Chat Completions MCP kostenlos zu verwenden?

A: Ja, es handelt sich um ein Open-Source-Projekt, was bedeutet, dass es kostenlos zu verwenden und zu modifizieren ist.

F: Kann ich zu dem Projekt beitragen?

A: Absolut! Beiträge sind willkommen. Sie können Probleme, Funktionsanfragen oder Pull-Requests im GitHub-Repository einreichen.

F: Welche Programmiersprachen werden unterstützt?

A: Der Server ist so konzipiert, dass er sprachunabhängig ist, aber die API kann leicht mit gängigen Programmiersprachen wie Python, JavaScript und Java angesprochen werden.

F: Wie melde ich Probleme oder Fehler?

A: Sie können Probleme oder Fehler melden, indem Sie ein Issue im GitHub-Repository erstellen und Details zu dem Problem angeben, auf das Sie gestoßen sind.

Durch die Nutzung von Any Chat Completions MCP können Entwickler die Konversationsfähigkeiten ihrer Anwendungen erheblich verbessern, was es zu einem leistungsstarken Werkzeug im Bereich der KI und des maschinellen Lernens macht.

Detail

Serverkonfiguration

{

"mcpServers": {

"any-chat-completions-mcp": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"ghcr.io/metorial/mcp-container--pyroprompts--any-chat-completions-mcp--any-chat-completions-mcp",

"npm run start"

],

"env": {

"AI_CHAT_KEY": "ai-chat-key",

"AI_CHAT_NAME": "ai-chat-name",

"AI_CHAT_MODEL": "ai-chat-model",

"AI_CHAT_BASE_URL": "ai-chat-base-url"

}

}

}

}